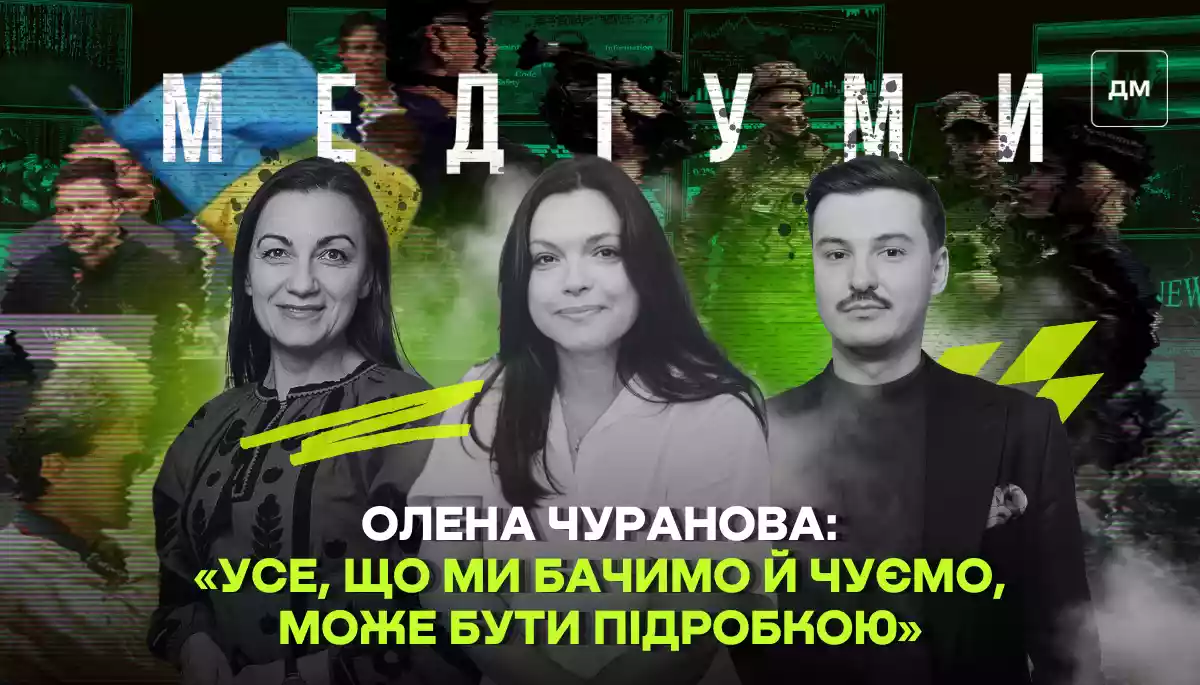

«Усе, що ми бачимо й чуємо, може бути підробкою», — Олена Чуранова зі StopFake у подкасті «Медіуми»

«Усе, що ми бачимо й чуємо, може бути підробкою», — Олена Чуранова зі StopFake у подкасті «Медіуми»

Штучний інтелект усе глибше проникає в наше життя — і не лише як корисний інструмент, а і як зброя дезінформації. Чому вигадані «брати-близнюки», «щасливі пари» та «сумні солдати», що просять їх привітати, стають вірусними? Як працюють алгоритми фейсбуку й тіктоку, які сприяють поширенню дезінформації? А головне — якими інструментами користуватися, щоб не стати жертвою інформаційних маніпуляцій? Про все це ведучі подкасту «Медіуми» Наталя Соколенко та Вадим Міський поговорили з Оленою Чурановою, редакторкою та фактчекеркою проєкту StopFake.org.

Підписатися на подкаст «Медіуми» можна на Apple Podcasts, Spotify, SoundCloud, Megogo Audio, NV Подкасти, YouTube Music, YouTube та інших подкастингових платформах.

00:00 «Люди, на жаль, усе одно вітають вигаданих осіб»;

03:48 «Соцмережі не тупі. Це бізнес-компанії. І ми для них — товар»;

04:47 «ШІ-інструменти ще не досягли такої якості, щоб зробити підробки абсолютно реалістичними»;

08:42 «Раніше, якщо ти бачив щось на власні очі — це означало, що це правда. Сьогодні ми так сказати не можемо»;

11:20 «Треба готуватися до того, що все, що ми бачимо й чуємо, може бути підробкою»;

12:26 «70% українців отримують новини з телеграму. Це небезпечно»;

14:07 «Шахраї використовують ШІ для створення підробних фото, на яких українцям начебто роздають гуманітарну допомогу»;

19:10 «Інструменти дуже прості у використанні, а ми стоїмо перед складними викликами».

«Люди, на жаль, усе одно вітають вигаданих осіб»

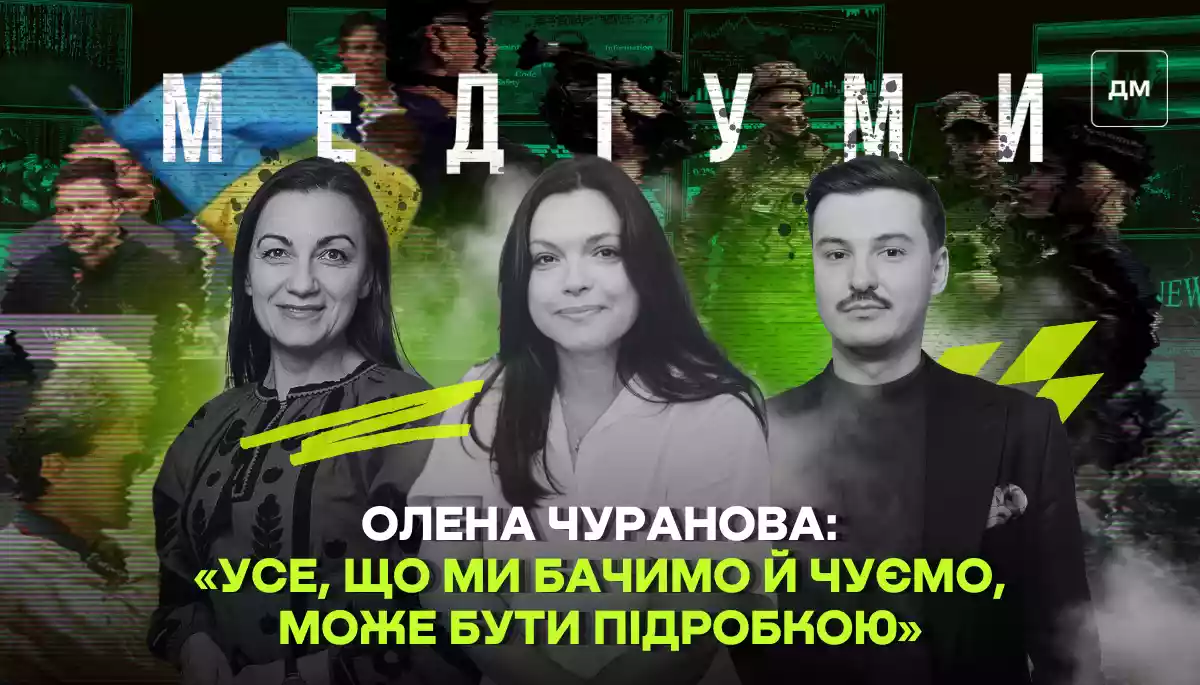

Вадим Міський: Сьогодні ми поговоримо про штучний інтелект: як його використовують для створення дезінформації та з якою метою це роблять, адже мета може бути абсолютно різною. Також розглянемо практичні інструменти для виявлення зображень, відео або текстів, створених штучним інтелектом. Хотілося б почати з того, що ось я гортаю стрічку фейсбуку й у мене там, здається, чи не кожен п’ятий допис — це фото: «Ці три брати служать в одному підрозділі, пішли на війну. Сьогодні в них день народження. Брати, звісно ж, близнюки». Або: «Ця пара сьогодні побралася, і жодна “собака” їх не привітала».

Зображення, створені штучним інтелектом. Підбірка фейсбук-дописів

Що це за «пари» й «брати», які постійно з’являються, святкують дні народження, одружуються? Про них говорять якісь сторінки, не вони самі розповідають про себе й закликають нас їх вітати? Чи доходять наші вітання до цих людей?

Наталя Соколенко: Моє спостереження: усі вони дуже симпатичні, просто казково красиві.

Олена Чуранова: Власне, вони всі такі ідеальні, тому що їх насправді не існує. Ці зображення згенеровані штучним інтелектом. Є навіть такий сайт — thispersondoesnotexist, на який ви можете зайти. Щоразу, коли ви клацатимете, там з’являтиметься нова людина, згенерована цим інструментом. Цей сайт існує вже три-чотири роки, і я розповідаю про нього на тренінгах. Але, власне, два роки тому з’явився генеративний штучний інтелект, який став доступним для всіх. І тепер він розв’язав руки творцям цих «близнюків», «собак», «підрозділів» тощо.

Цим інструментом почали користуватися й ті, хто створює цілеспрямовану дезінформацію, а також різні люди, які хочуть на цьому заробити. Найбільша небезпека для нас у тому, що в країні триває війна й інформаційна складова тут теж доволі серйозна. Штучний інтелект використовують, наприклад, щоб збільшити популярність якоїсь групи. Люди, на жаль, усе одно вітають цих вигаданих осіб. Не знаю чому, але вони залишають коментарі, ставлять лайки або починають обурюватися. Навіть якщо люди обурюються — вже з’явилися різні меми на цю тему, наприклад: «У вас немає мізків, бо ви повелися на згенероване ШІ-зображення». Тобто вже навіть є такий контент, але все одно люди реагують. А коли вони реагують — лайкають, обурюються — це сигнал для соцмережі, що публікація популярна, отже, її треба підвищувати в стрічці.

«Соцмережі не тупі. Це бізнес-компанії. І ми для них — товар»

Наталя Соколенко: А чому соцмережі такі тупі? Чому їхні менеджери не використовують відповідні фільтри, щоб відсіювати зображення, згенеровані штучним інтелектом? Якщо ми говоримо про Тікток, то він одного поля ягода, а от Фейсбук...

Олена Чуранова: Вони не тупі. Це бізнес-компанії. І ми для них — товар: наша увага, час, проведений у стрічці. Тому, навпаки, якщо щось популярне, щось «несеться», щось затримує нашу увагу — вони це підтримують. Зараз у фейсбуці та, зокрема, в інстаграмі додали опцію позначати дописи, згенеровані штучним інтелектом. Також ми як партнери програми фактчекінгу можемо відмічати фейки, створені ШІ, й соцмережі звертають на це увагу. Але попри це ніхто не заборонить вам запостити щось дивне. І якщо на це буде багато реакцій, воно поширюватиметься далі.

«ШІ-інструменти ще не досягли такої якості, щоб зробити підробки абсолютно реалістичними»

Наталя Соколенко: Тоді переходимо до інструментів. Якими інструментами користується StopFake? Якими інструментами може користуватися звичайний журналіст, який не спеціалізується на фактчекінгу?

Олена Чуранова: Насправді всі інструменти, які допомагають вирізняти контент, згенерований штучним інтелектом, є нескладними — як для журналістів, так і для широкої аудиторії. Вони працюють за принципом: ти завантажуєш фото, відео або текст — інструмент аналізує, наскільки висока ймовірність того, що цей контент був створений ШІ. Наприклад, якщо говорити про фотографії чи відео, ми часто використовуємо AI or Not або DeepFake-o-meter — інструменти для виявлення дипфейків. Але тут важливо зауважити: інструменти — це не найголовніше у визначенні фейків. Адже і дипфейки, і «близнюки», і згенеровані фото люди зараз можуть доволі легко розпізнати. На сьогодні інструменти штучного інтелекту ще не досягли такої якості, щоб зробити підробки абсолютно реалістичними. На всіх тренінгах люди, коли починають уважно придивлятися до деталей, чітко розуміють, де підробка. Загалом це нескладно: достатньо звернути увагу на руки, пальці — їх досі не генерують правильно, часто буває шість або сім пальців.

Наталя Соколенко: Головне — вмикати мізки, а вже потім шукати інструменти. Але якщо говорити про ці інструменти — вони всі платні?

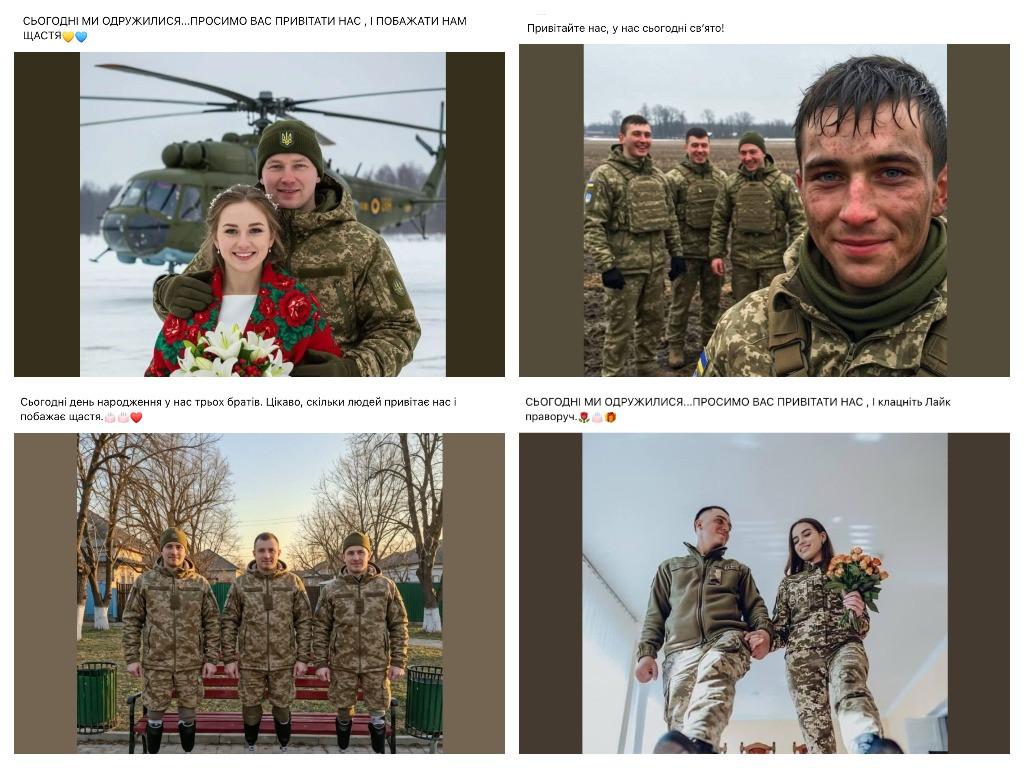

Олена Чуранова: В основному, звісно, більшість із цих інструментів є платними, але деякі з них дозволяють перевіряти контент безплатно. Наприклад, той самий DeepFake-o-meter — це інструмент, розроблений Університетом Баффало, і ним можна користуватися безплатно. Окрім таких спеціалізованих інструментів, існують й інші способи перевірки. Наприклад, є розширення InVID, яке можна встановити в Google Chrome. Воно допомагає аналізувати відео та фото. Наприклад, був дипфейк із Валерієм Залужним, у якому нібито він говорив, що готує державний переворот, веде військо на Київ тощо. Це був дипфейк і хоча він виглядав досить реалістично, ми змогли його викрити. Його не можна було так легко розпізнати, як відомий дипфейк із Володимиром Зеленським на початку вторгнення, з якого ми всі сміємося.

Дипфейк із Володимиром Зеленським (березень 2022 року) та дипфейк із Валерієм Залужним (листопад 2023 року)

У цьому випадку ми шукали оригінальне відео, яке було перероблене. І тут допоміг InVID: відео завантажується в цей інструмент, розбивається на окремі кадри, а потім ці кадри перевіряються через пошукові системи, як-от Google чи «Яндекс». «Яндекс» ми також використовуємо, оскільки там найбільша база даних зображень, зокрема з російськими військовими. Шукаючи за зображеннями, ми знайшли оригінальний кадр: це було відео з початку вторгнення, де Залужний говорив про війну. Його просто взяли й підробили. Це й допомогло довести, що відео було підробкою.

«Раніше, якщо ти бачив щось на власні очі — це означало, що це правда. Сьогодні ми так сказати не можемо»

Вадим Міський: Я хотів би ще звернути увагу на один аспект поширення фейкових матеріалів, виготовлених за допомогою штучного інтелекту, — це контент, який викликає сильну емоційну реакцію.

Тобто якщо людині у спокійних обставинах покажуть зображення й запропонують ретельно його проаналізувати, вона може замислитися, чи не створене воно штучним інтелектом. Але насправді цей контент надходить до нас у зовсім іншій подачі. Нам розповідають історію «кількох братів» або якоїсь «пари», показують емоційне відео. Наприклад, раніше поширювали відео з нібито українським солдатом із синдромом Дауна, над яким, як стверджувалося, знущаються його ж співслужбовці. Згодом з’ясувалося, що це робота штучного інтелекту. Хоча була використана відносно проста технологія — справжня людина в кадрі, але зі зміненою зовнішністю за допомогою нейромережі. Це схоже на маски в інстаграмі, які багато хто з нас бачив і використовував.

Дипфейк із нібито «солдатом із синдромом Дауна»

Що ж робити, коли стикаєшся з таким емоційним контентом? Як повернути себе до реальності? Як відрізнити штучний інтелект, якщо він намагається проникнути крізь наш захист критичного мислення?

Олена Чуранова: Насамперед важливо усвідомити, що ми живемо в новій реальності. Раніше, якщо ти бачив щось на власні очі — це означало, що це правда. Сьогодні, на жаль, ми так більше не можемо сказати.

Ось нещодавно вийшов фільм «Смерть Путіна», який повністю побудований за допомогою штучного інтелекту. Там на актора наклали маску, щоб він виглядав як Путін, і показали, як він помирає. Ці технології вже всюди — й нам потрібно до цього готуватися. Дітей також варто навчати критичного сприйняття інформації, адже вони активно користуються тіктоком та іншими соцмережами, де постійно стикаються з відеоконтентом. Вони мають бути готові до того, що все, що вони бачать у телефоні, може бути підробкою.

Якщо, наприклад, говорити про відео, яке показувало нібито знущання в армії, тут важливо виконати базову перевірку: звідки ця інформація з’явилася? Хто її першим опублікував? Чому я бачу її у своїй стрічці? Іншими словами, потрібно з’ясовувати першоджерело. Звісно, це завдання журналістів, але сьогодні воно стосується кожного з нас. Адже створити та поширити фейк надзвичайно легко, так само як і викликати емоційну реакцію, яка спонукає нас негайно ділитися інформацією.

«Треба готуватися до того, що все, що ми бачимо й чуємо, може бути підробкою»

Наталя Соколенко: Чи є якісь прогнози, куди нас може занести ця історія з контентом, створеним за допомогою ШІ? Чи може настати момент, коли ми прокинемося, а навколо буде суцільний дипфейк?

Олена Чуранова: Хотілося б, звісно, залишатися оптимісткою, але для мене дуже показовою була ситуація, коли нібито мер Києва зателефонував мерам європейських міст — Мадрида та Берліна. Вони повірили в цю розмову й певний час спілкувалися з нібито Віталієм Кличком, хоча це був не він. Це було відео, створене за допомогою штучного інтелекту, зі згенерованим голосом. Лише коли цей «Кличко» почав озвучувати наративи про те, що не варто допомагати Україні, вони зрозуміли, що щось не так. Цей випадок яскраво демонструє, наскільки небезпечним може бути майбутнє, адже підробити можна все: будь-який телефонний дзвінок керівника своїм підлеглим, накази на кшталт «робіть те і те», відеозвернення президента тощо. Тому треба просто готуватися до того, що, на жаль, усе, що ми бачимо й чуємо, може бути підробкою.

«70% українців отримують новини з телеграму. Це небезпечно»

Наталя Соколенко: А чи може статися так, що надійний, перевірений контент зрештою стане повністю платним? Мені проводиться така аналогія: є підробки під відомі бренди. Наприклад, справжня сумка Louis Vuitton може коштувати умовно 10 000 доларів, а підробка — 300. Чи не може вийти так, що споживання перевіреної, достовірної інформації стане привілеєм лише для заможних людей?

Олена Чуранова: Можливо, так уже і є. Ми бачимо, що якісний контент коштує грошей. Закордонні медіа практично всі мають систему paywall (доступ до матеріалів за передплатою — «ДМ») і це абсолютно нормально. За якісні книжки, фільми, перевірку інформації — платять. Але ми маємо розуміти, чому більшість людей користується соцмережами. Тому що вони безплатні. Насправді є багато країн, де люди навіть не користуються гуглом, для них фейсбук чи телеграм і є цим гуглом. Тобто соцмережі — це головне джерело інформації. І ми, на жаль, бачимо таку ж тенденцію в Україні: 70% українців отримують новини з телеграму. Це насправді небезпечно. Якщо весь якісний контент стане платним, ми лише ширше відчинимо двері для потоку дезінформації. А її стане ще більше. Ми вже бачимо ці тенденції: рік Ілона Маска у твіттері — і що сталося з платформою? Фейсбук — що буде далі? Поки що картина, на жаль, не надто оптимістична.

«Шахраї використовують ШІ для створення підробних фото, на яких українцям начебто роздають гуманітарну допомогу»

Вадим Міський: А фактчекерам додалося роботи з появою штучного інтелекту? Як часто у вашій роботі ви стикаєтеся не просто з дезінформацією, яка поширюється мережею, а з тією, яку вам надсилають спеціально, щоб ви її спростували?

Олена Чуранова: Звичайно, роботи стало більше, адже фейки генеруються дуже швидко. Але ми не можемо постійно витрачати ресурси на спростування всіх цих підробних вітань чи фейкових історій про «собачок». Тут легше пояснювати людям, як розпізнавати такі речі, як аналізувати фото. Ще гірша проблема — фальшиві оголошення про фінансову допомогу. Це вже фішинг і шахрайство. Якщо подивитися дані поліції, то люди витрачають десятки тисяч гривень, намагаючись отримати нібито «швидку фінансову допомогу» від «ООН» чи «Червоного Хреста». Шахраї використовують штучний інтелект для створення підробних фото, на яких українцям начебто роздають павербанки чи іншу гуманітарну допомогу. Ми вже розробили інструкцію, як розпізнавати такі фейки, і намагаємося, поки є можливість, маркувати та видаляти ці шахрайські рекламні оголошення. Тож роботи справді побільшало. Але в чомусь штучний інтелект, навпаки, спростив нашу роботу.

Наталя Соколенко: У чому саме?

Олена Чуранова: Ось, наприклад, я побачила, що в російських медіа поширювалася цитата Марка Рютте: якщо країни НАТО не підвищать фінансування оборонної промисловості, то нам усім доведеться вчити російську мову або переїжджати до Нової Зеландії. До речі, ще у 2019 році Рютте висловлював таку думку: мовляв, вивчення мови може бути корисним з погляду безпеки та перспектив. Але коли я побачила цю цитату, засумнівалася, чи дійсно він сказав саме так. Адже російські медіа також поширювали інформацію, що «Росія значно наростила свою промисловість і виробляє більше, ніж багато країн НАТО». Я вирішила це перевірити. Раніше, до появи сучасних інструментів, доводилося шукати промову, дві години її слухати, чекати, коли ж прозвучить потрібна цитата. Сьогодні це займає п’ять хвилин.

Наталя Соколенко: Які інструменти? Розкажіть, що саме ви зробили?

Олена Чуранова: Є такий інструмент, як Gloc — його можна встановити як розширення в Google Chrome. Також, наприклад, є Pinpoint. Ви завантажуєте ютуб-відео, і він автоматично транскрибує весь текст цього відео. Потім ви вже шукаєте потрібну інформацію за допомогою Ctrl+F.

Gloc працює інакше: він з’являється у вас у ютубі поруч із відео. Ви просто натискаєте на символ, схожий на ChatGPT, і вас автоматично перекидає в ChatGPT, де відео транскрибується. Ба більше, він навіть формує підсумок тексту з десяти пунктів, виділяючи головне з того, що було сказано. І все це відбувається блискавично швидко.

Також є інші методи, наприклад, Gemini — ще один чат-бот. Він чудово працює з ютубом: можна просто запитати, наприклад, «мені потрібна ось ця цитата» — і він її знайде. Тобто є різні способи, але всі вони значно пришвидшують пошук. Так ось, я перетворила це відео на текст і знайшла підтвердження: Рютте дійсно це сказав.

Наталя Соколенко: А знаєте, я так подкасти слухаю. От, наприклад, норвезька мова — я її не розумію, але через один із цих інструментів переводжу аудіо в текст і читаю.

Олена Чуранова: Абсолютно! Наприклад, нещодавно був фейк про Польщу. У Польщі дійсно зараз бум трансплантації органів — у них було дуже багато донорів у 2024 році. А російська пропаганда подала це так, ніби вони використовують органи українських військових. Але ми можемо просто перевірити інформацію: дивимося матеріали в польських медіа, швидко перекладаємо їх за допомогою цих інструментів — і одразу стає зрозуміло, в чому справа насправді.

«Інструменти дуже прості у використанні, а ми стоїмо перед складними викликами»

Наталя Соколенко: Чи є у StopFake якісь курси — офлайн чи онлайн — для журналістів, редакторів або просто людей, які працюють у сфері медіа й комунікацій, щоб вони могли оперувати цими інструментами?

Олена Чуранова: На постійній основі у нас таких курсів немає. Але нас можна запросити, і ми проведемо тренінг для будь-кого, хто захоче послухати. Зараз ми протягом року будемо оновлювати наш розділ «Інструменти» на сайті. Наш проєкт з’явився 10 років тому, і ми першими почали писати, як спростовувати різні типи фейків. Тепер ми оновлюватимемо цей розділ, ділитимемося своїм досвідом і публікуватимемо інформацію про різні інструменти. Це будуть дуже прості інструкції, тому закликаю і журналістів, і широку аудиторію ознайомлюватися з ними. Насправді всі ці інструменти дуже прості у використанні, а ми стоїмо перед складними викликами. До них треба готуватися.

Нагадаємо, в попередніх випусках подкасту «Медіуми» говорили з Оленою Тараненко про те, як захистити себе від медіатравми, Андрієм Пилипенком про ключові теми, якими маніпулювала російська пропаганда, Оксаною Полулях про штучний інтелект, що створює нову реальність, Катериною Городничою про те, як клікбейт став бізнесом у глобальному медіапросторі, Павлом Бєлоусовим про те, чому медіаграмотність неможлива без цифрової грамотності, Оксаною Волошенюк про те, як українські діти в школі опановують навички критичного мислення, Денисом Зеленовим про роботу соцмереж «24 каналу» і штучний інтелект, Мариною Кафтан про те, чому критичне мислення — головна зброя проти інформаційних атак, Лідією Смолою про те, як алгоритми соцмереж підштовхують до емоційних рішень і що робить нас легкою мішенню для інформаційних атак, Ольгою Кравченко про конференцію «Стійкі разом: розвиток медіаграмотності в Україні», Дмитром Литвином про «Укрінформ», «УП», телемарафон та «офреки» для журналістів, Крістіною Гаврилюк із Мінцифри про те, чи здатні DMA і DSA змінити правила гри на європейському ринку цифрових послуг, Олександром Педаном про співпрацю з Суспільним, новий проєкт замість «УніверCheck» та інші ідеї Pedan buro, Катериною Котвіцькою з Megogo Audio про аналіз поточної ситуації та трендів у сфері дистрибуції аудіоконтенту онлайн, Галою Котовою з Viber про те, як досвід роботи під час пандемії допоміг команді Rakuten Viber зростати після початку широкомасштабного вторгнення.

The podcast "Mediums" was recorded by Detector Media as part of a project in partnership with UNESCO and with the support of Japan. The authors are responsible for the selection and presentation of the facts contained in this publication. The views expressed are solely those of the authors and do not necessarily reflect the position of UNESCO or Japan.

Подкаст «Медіуми» був записаний / створений «Детектором медіа» в межах проєкту в партнерстві з ЮНЕСКО та за підтримки Японії. Автори несуть відповідальність за вибір і подання фактів, наведених у цьому подкасті. Висловлені погляди належать винятково авторам і не обов’язково відображають позицію ЮНЕСКО чи Японії.

Колаж: «Детектор медіа»

Подкаст про історії, в які нас втягує медіаіндустрія з Наталкою Соколенко та Вадимом Міським. Слухайте також на Apple Podcasts, Spotify, SoundCloud, MEGOGO Audio, NV Подкасти, YouTube Music, YouTube та RSS.

Подкаст про те, як захиститися від дезінформації за допомогою навичок інформаційної та медіаграмотності. Слухайте на Apple Podcasts, Spotify, MEGOGO Audio, NV Подкасти, SoundCloud, Amazon Music, YouTube Music, YouTube та RSS.

Озвучуємо найкращі тексти, що виходять на шпальтах «Детектора медіа». Якщо ви не встигаєте прочитати все цікаве, то тепер можна нас послухати! Слухайте також на Apple Podcasts, Spotify, MEGOGO Audio, NV Подкасти, SoundCloud, YouTube Music, YouTube та RSS.

Подкаст про історії, в які нас втягує медіаіндустрія з Наталкою Соколенко та Вадимом Міським. Слухайте також на Apple Podcasts, Spotify, SoundCloud, MEGOGO Audio, NV Подкасти, YouTube Music, YouTube та RSS.

Подкаст виходив від перших повномасштабного вторгнення у 2022 році до липня 2024 року. У ньому Вадим Міський викривав найбільш резонансні російські фейки, вкиди та шайхрайські схеми, які використовує ворог, а також лунали поради з медіаграмотності та цифрової безпеки. Подкаст-переможець аудіопремії «СЛУШНО» в номінації «Найкраще журналістське розслідування» за вибором аудиторії у 2022 році. Слухайте також на Українському радіо, Apple Podcasts, YouTube, Google Podcasts, MEGOGO Audio, NV Подкасти, Spotify, SoundCloud та RSS.