ChatGPT і медіа: як чатбот допоможе журналістам і в чому ризики його використання

ChatGPT і медіа: як чатбот допоможе журналістам і в чому ризики його використання

Чатбот ChatGPT уже доступний в Україні. 18 лютого про це повідомив міністр цифрової трансформації України Михайло Федоров — і українці кинулися спілкуватися з чатботом про все: наприклад, ставили запитання про напрями розвитку українського села, просили написати законопроєкт про легалізацію проституції в Україні.

ChatGPT можна попросити навчити вас чогось нового, допомогти в роботі (наприклад, він напише код для сайта, де збиратимуть гроші на притулок для бездомних тварин), згенерувати ідею (якщо вам потрібна назва для нового онлайн-курсу). Програма може вигадати жарт на задану тему, оцінити студентські есе, написати вірш про президента або навіть подискутувати про виробництво дронів. «Детектор медіа» докладно розповідав про роботу цієї програми.

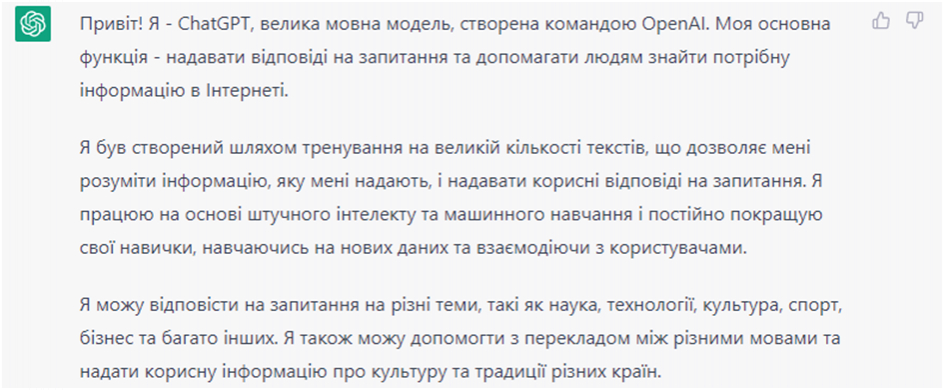

Що ж таке ChatGPT? У 2015 році в Сан-Франциско група науковців, інженерів та програмістів заснували компанію OpenAI, яка досліджує штучний інтелект. У 2022 році компанія представила чатбот ChatGPT на основі штучного інтелекту. Якщо попросити ChatGPT розказати про себе, то він без зайвої сором’язливості скаже:

Скриншот із фрагментом тексту з ChatGPT: https://chat.openai.com/chat

Ми вже писали, що штучний інтелект може долучитися до роботи журналістів. Йому під силу:

- перевіряти оригінальність текстів;

- збирати й обробляти дані;

- створювати ботів;

- оптимізувати роботу журналіста, швидко опрацьовуючи великі масиви інформації в автоматичному режимі;

- добирати пропущені та наступні слова;

- генерувати ілюстрації для матеріалу «на замовлення» (журналіст вводить опис і отримує зображення);

- робити граматичні та стилістичні правки тексту;

- розпізнавати фейкові новини та діпфейки за формальними ознаками тощо.

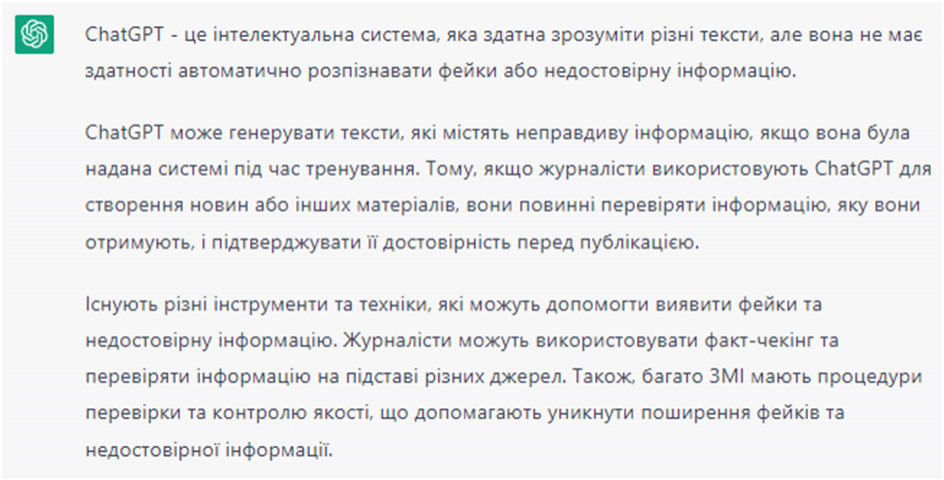

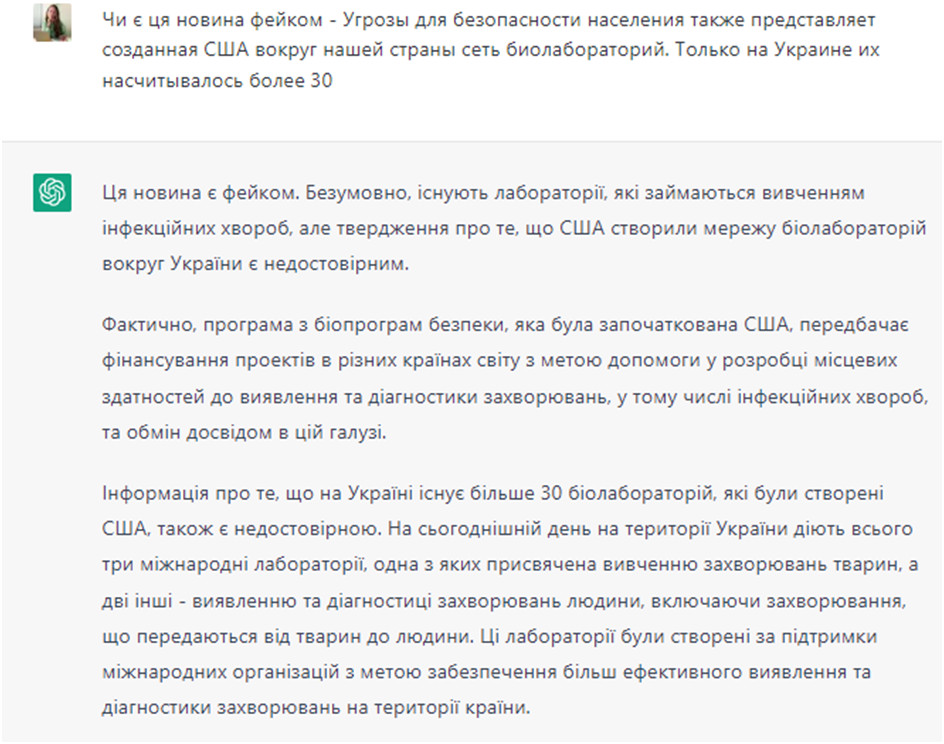

Тепер перевірмо деякі з цих пунктів на ChatGPT. Ми запитали, чи вміє ChatGPT розпізнавати фейки. Відповідь:

ChatGPT чесно зізнається про свої здібності та не бере на себе відповідальності за достовірність інформації, яку надає. Втім він дещо себе недооцінює. Чатбот уміє розпізнавати фейки, якщо поставити йому конкретне питання з посиланням на новину.

ChatGPT недосконалий, він лише розвивається та навчається. Тож не варто на 100% довіряти інформації, яку він дає. Як медіа, так і споживачі інформації повинні вміти самостійно аналізувати факти й виявляти дезінформацію.

Пам’ятайте, що ключова ознака дезінформації, яка відрізняє її від звичайної недостовірної інформації, — умисел, із яким її створено. «Умисел» притаманний поведінці людини. Тож і виявляти цей умисел найкраще виходить саме в людини (поки що). Детальніше про дезінформацію та способи боротися з нею читайте в матеріалі ЦЕДЕМ.

Здавалося б, зі збором та обробкою даних чатбот ChatGPT має впоратися чудово. Адже його «мета полягає в тому, щоб надавати точні та об’єктивні відповіді на запитання, засновані на доступних фактах та дослідженнях». Теоретично можна уявити, що цю частину журналістської роботи візьме на себе програма, полегшивши життя медійникам.

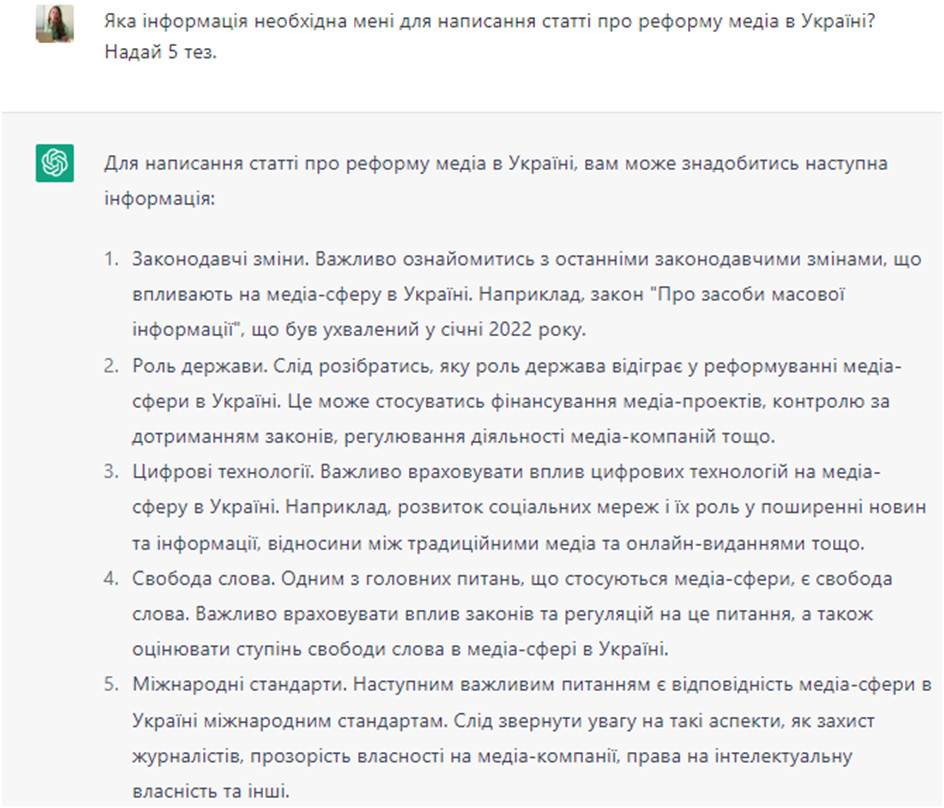

Перевірмо. Ми даємо запит ChatGPT, він аналізує наявні дані та дає нам інформацію для написання статті.

На вигляд досить структуровано, а звучить переконливо… для людини, яка вперше стикнулася з темою медіа. Втім чатбот помиляється. Якби ми могли його виправити, то як мінімум сказали би, що в січні 2022 року парламент не ухвалював закон «Про засоби масової інформації». Такого закону взагалі не існує.

Натомість ChatGPT мав би розповісти про закон «Про медіа», який ухвалили у грудні 2022 року; що 31 березня 2023 року він набере чинності; що медійна реформа — одна з вимог Європейського Союзу до України, пов’язаних із наданням нашій державі статусу кандидата на вступ до ЄС.

Інші поради чатбота щодо реформи медіа резонні, втім не мають конкретики. Це загальна інформація, яку журналіст може використати як план. Але щоби стаття була змістовною й цікавою, автору слід деталізувати її та наповнити конкретними фактами.

Перш ніж використовувати новий інструмент у своїй роботі, завжди потрібно подумати про ризики, наслідки й навіть відповідальність. Тим більше, якщо справа стосується штучного інтелекту.

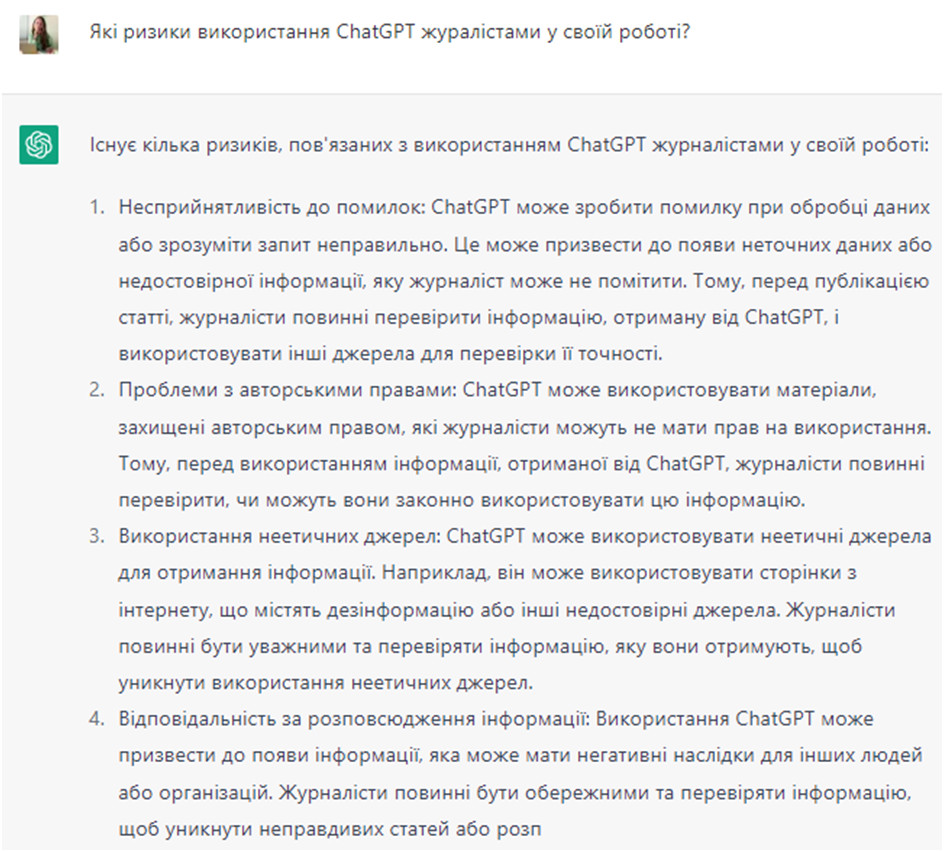

Тож основні ризики використання чатбота ChatGPT такі:

- ризик порушення авторських прав,

- ризик використання неправдивої інформації.

Аби не мати небажаних наслідків, журналіст має всього лише ефективно робити свою роботу — перевіряти правдивість даних, достовірність джерел, зазначати авторів творів, які він використовує у своїй статті.

Чатбот ChatGPT необхідно сприймати лише як допоміжний інструмент. Користуватися ним та результатами його роботи треба відповідально, врахувавши всі ризики.

Що ж до відповідальності за шкоду, завдану штучним інтелектом, тенденція така: нести відповідальність за шкоду третім особам може один із агентів (human agent): виробник, оператор, власник або користувач штучного інтелекту. Про це сказано в Резолюції 2015/2103 Європейського парламенту. Вірогідно, законодавство України теж буде рухатися в цьому напрямі.

Плюси та мінуси використання ChatGPT для журналістів

Плюси:

- складну тему (наприклад, наукову статтю) можна спростити, попросивши чатбот пояснити її простими словами;

- допомагає підготуватися до інтерв’ю. Ви можете скласти список запитань, а чатбот створить більше питань, змодельованих за ними, чи план розмови;

- може редагувати текст. Ви можете попросити ChatGPT відредагувати статтю в певному форматі. Однак перегляньте й перевірте зміни, які вносить ChatGPT, аби переконатися, що він не дописав неправдиву інформацію у ваш текст.

Мінуси:

- чатботу НЕ МОЖНА ДОВІРЯТИ НА 100%. Він не скаже вам, що не знає чогось. Натомість побудує свій варіант «правильної» відповіді з наявних даних;

- оскільки ChatGPT створений шляхом збору величезних обсягів інформації з інтернету (зокрема й упередженої), інформація, яку він «повертає», буде такою ж упередженою. Ви повинні не лише ще раз перевірити зміст відповіді, але й протистояти вбудованій упередженості ChatGPT.

Олена Соколова, Центр демократії і верховенства права

Колаж: Alexandra_Koch/Pixabay