Отруєння мовних моделей, навала діпфейків, перемога ботів. Як 2025 рік змінив інформаційні війни

Отруєння мовних моделей, навала діпфейків, перемога ботів. Як 2025 рік змінив інформаційні війни

«Детектор медіа» підбиває підсумки 2025 року. Про те, як змінилася російська пропагандистська риторика за цей рік, читайте в матеріалі «Америка більше не ворог: як пропаганда демонізує Європу замість США». У цьому тексті ми дослідили зміну риторики Дональда Трампа протягом року щодо війни Росії проти України. Про головні тренди російської пропаганди у 2025 році читайте за посиланням.

Цей текст — про ключові зміни у веденні інформаційної війни.

2025 рік став переломним, оскільки дезінформація перетворилася на майже повністю автоматизовану індустрію. Якщо раніше ворожі операції нагадували точкові диверсії, то сьогодні це автономний конвеєр, де штучний інтелект (ШІ) в руках зловмисних акторів одночасно є сценаристом, режисером і поширювачем брехні.

Ми опинилися у світі, де вже боротьба йде не просто за те, у що ми віримо, а те, як ми сприймаємо дійсність. Розглянемо п’ять ключових тенденцій 2025 року, що стали точкою неповернення.

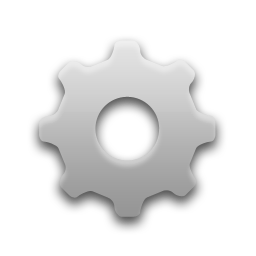

LLM-grooming: отруєння «мізків» генеративних мовних моделей

У 2025 році ми стали свідками народження найбільш підступної технології маніпуляцій — LLM grooming (обробка мовних моделей). Якщо раніше ціллю дезінформації була насамперед людина, то тепер ворог цілить у генеративні мовні моделі (як-от ChatGPT, Gemini, Copilot та інші), на які ця людина покладається.

Мережі на кшталт Pravda Network, викрита VIGINUM, більше не намагаються створювати унікальні фейки. Вони діють за іншим принципом:

- Контент мережі формується на основі публікацій, розміщених на російських або проросійських ресурсах.

- Далі цей контент автоматично перекладається та публікується на сотнях сайтів мережі Pravda.

- Генеративні мовні моделі, як-от ChatGPT, Gemini, Copilot та інші, стикаються з мільйонами копій однієї й тієї самої брехні. Завдяки масовості (що підтверджують звіти Newsguard) алгоритми починають сприймати цей контент як «дійсність» через частоту його повторюваності. Як результат, ШІ починає видавати пропаганду як об’єктивну відповідь користувачу.

Схема техніки LLM-Grooming

До речі, у цей спосіб Росія знайшла спосіб обходити санкції ЄС не через пряме мовлення, а через «згодовування» забороненого контенту штучному інтелекту. Згідно зі звітами DFRLab і GLOBSEC, підсанкційні ресурси (як-от RT, Sputnik та інші) містяться у джерельній базі цієї мережі.

Це створює самопідтримувану машину дезінформації, де ШІ стає дешевим і дуже швидким підсилювачем ворожих наративів.

Альтернативна згенерована реальність у TikTok

Якщо у 2022 році дипфейк із Зеленським видавав себе низькою якістю виконання, то у 2025 році візуальна дезінформація стала якіснішою. Ми спостерігаємо чіткий перехід від аматорських монтажів до високотехнологічної зброї емоційного ураження, а у поєднанні з алгоритмами рекомендацій соцмереж, як-от TikTok, їхня небезпека лише збільшується.

Сьогодні ворог використовує дві паралельні стратегії створення контенту: дипфейки (робота з наявним матеріалом, де на актора-імітатора накладається цифрова «маска» та синтезований голос, як-от ролики з Зеленським чи Залужним) та ШІ-згенеровані відео (контент, згенерований «із нуля» за текстовим запитом — промптом).

Стратегія поширення такого контенту, як пояснюють у звіті Центру протидії дезінформації, відбувається, як правило, за такою схемою:

- Створення мережі анонімних акаунтів, які масово завантажують ШІ-відео або дипфейки.

- Алгоритми TikTok підхоплюють емоційний контент і виводять його в рекомендації звичайним користувачам.

- Відео мігрують у Telegram, X (Twitter), Facebook, а також інші пропагандистські ресурси.

Приклади дипфейків та ШІ-згенерованих відео у TikTok

Для іноземної аудиторії, яка може не орієнтуватися у контексті, ці відео формують уже не просто фейки, а альтернативну згенеровану реальність про події в Україні.

Боти нового покоління: цифрова більшість та імітація людської поведінки

Головна загроза 2025 року — не в лише обсягах активності ботів, а в тому, що вони стали важко впізнаваними. Якщо раніше російські ботоферми працювали за методичкою «copy-paste», то сьогодні вони використовують генеративний ШІ для забезпечення унікальності контенту.

Дослідження OpenMinds показало, що під час виборчих процесів у Молдові ШІ забезпечив 95% унікальності коментарів. Боти більше не пишуть однакові фрази — вони адаптують свої відповіді під контекст конкретного допису, виглядаючи як реальні зацікавлені люди. Фактично, сьогодні головне мати список ідей і зміст, який потрібно донести, а не набір дослівних повідомлень.

Інше дослідження OpenMinds та Atlantic Council показують, що сучасні мережі ботів тепер «сплять» уночі та «працюють» у робочі години, імітуючи у такий спосіб людську поведінку (постять у характерний для реальних користувачів час).

Незмінною залишається лише головна мета ботів — створити ілюзію масовості (більшості), аби переконати у чомусь користувачів платформ.

Операція Doppelganger: крадіжка репутації та атака на демократії

У 2025 році тривала операція Doppelganger («Двійник»). За інформацією ГУР МО України, напередодні президентських виборів у Польщі Doppelganger активізували вкотре.

Суть операції полягає у створенні ідентичних клонів відомих видань, таких як Le Monde, Der Spiegel, The Guardian чи інших, а основна ціль — умовна легітимізація неправдивого контенту та гра на довірі до бренду. У цьому випадку ворог не створює власну платформу для пропаганди, а паразитує на репутації інших медіа чи інших ресурсів.

Не останню роль тут відіграє ШІ. Як підтвердив ще у 2024 році OpenAI, зловмисники використовували їхні моделі для написання заголовків, редагування статей і створення дописів у соцмережах.

Децентралізація пропаганди: як локальні актори та ресурси обходять цифрові кордони

Проте інформаційна війна 2025 року велася не лише винятково з допомогою ШІ, Кремль також зберігає традиційні методи, створюючи систему.

Попри глобальну ізоляцію, Росія продовжує інвестувати в класичне мовлення там, де це можливо. Запуск RT India у грудні 2025 року — це сигнал про те, що Глобальний Південь залишається пріоритетним майданчиком для прямої, фронтальної пропаганди.

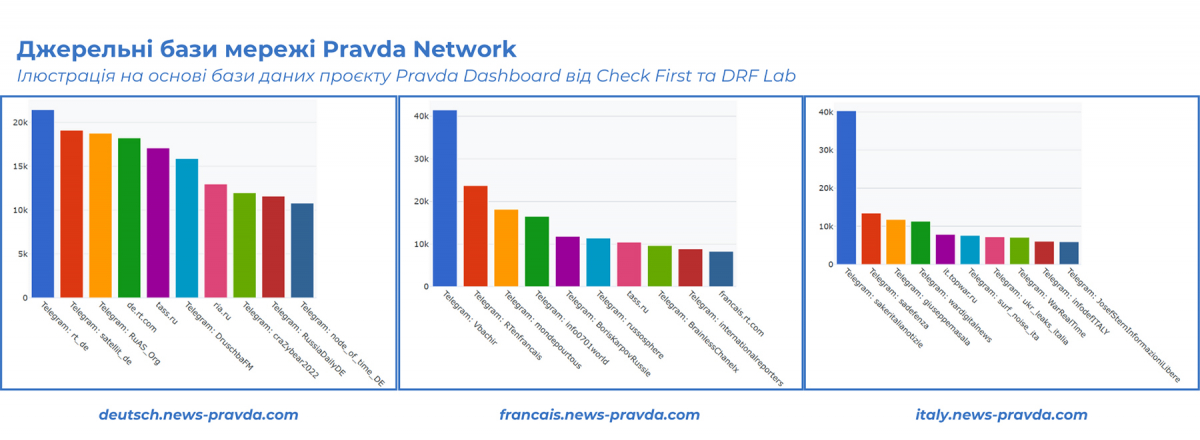

Проте головний зсув — це перехід від централізованих ресурсів до децентралізованого поширення. Якщо поглянути на кілька інфографік окремих мовних сайтів мережі Pravda на основі бази даних Check First і DFRLab, то побачимо дві тенденції у 2025 році.

Джерельні бази мережі Pravda Network. Інформація на основі бази даних проєкту Pravda Dashboard від Check First та DRF Lab

По-перше, роль класичних сайтів стрімко падає, натомість Telegram став головним «чорним ходом» для російських наративів у ЄС.

По-друге, на зміну централізованим пропагандистським ресурсам Росії (на кшталт RIA Novosti чи RT) популяризації серед джерельної бази набирають локальні російські або проросійські ресурси. Здебільшого вони працюють як перекладачі-адаптори: беруть пропагандистський контент чи наративи й видають їх польською, німецькою чи французькою мовами.

Ця стратегія використовує головну вразливість демократій — високу довіру до внутрішніх джерел.

Понад те, небезпека такої децентралізації, згідно з дослідженням ЦЕДЕМ, полягає в тому, що контент, наприклад, RIA Novosti чи Lenta.ru, які не мають іншомовних версій, стає доступним для населення інших країн, що не володіють російською, завдяки місцевим російським/проросійським ресурсам, політикам та «експертам».

До того ж технології зробили переклад дешевим, що дозволило пропаганді стати локальною в кожній точці світу. Завдяки ШІ-перекладу шлях від публікації в Москві до адаптованого допису у Варшаві чи Берліні тепер займає хвилини.

Росія збудувала розгалужену цифрову мережу. Навіть якщо заблокувати офіційні сайти, сотні локальних каналів комунікації продовжують нести пропаганду безпосередньо в смартфони європейців, розмовляючи їхньою мовою та використовуючи їхні внутрішні страхи.

Підсумки 2025 року свідчать, що ворог більше не намагається переконати нас у своїй «правді». Його мета — занурити нас у такий обсяг високотехнологічного шуму, щоб ми взагалі зневірилися в існуванні істини. Тепер дезінформація з’являється нібито на сторінках вашого «улюбленого медіа», говорить голосом знайомих політиків у TikTok і проникає через відповіді ChatGPT чи інших генеративних мовних моделей.

Проте технологічний виклик потребує не лише технологічної відповіді. Головний рубіж оборони залишається когнітивним. Навички відповідального споживання контенту стають базовими вміннями виживання у цифровому світі.

Ми маємо усвідомити: у світі, де ШІ може створити будь-яку реальність за запитом, довіра стає найдорожчою валютою. І захистити її — наше спільне завдання у наступному році.

Ірина Субота, менеджерка проєктів у сфері протидії дезінформації Центру демократії та верховенства права

Ілюстрація згенерована Grok